这是2019 CVPR一篇做SR的论文,借鉴style transfer的思路,这里简要梳理一下。

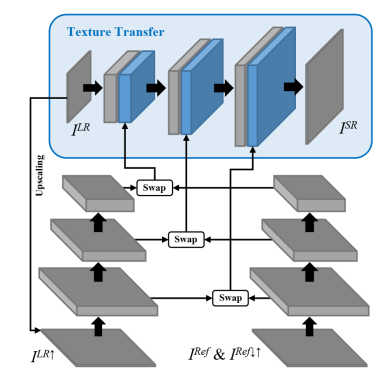

论文借鉴的思路是refSR,但是refSR需要两张相似的图像且对齐,否则效果会很差。而传统的SISR的问题是为了生成更好的纹理会使用感知类损失,但是会产生假的纹理和artifact。所以refSR理论上应该有效利用ref图片,即使内容不一致,也不比不使用SISR更差。所以这篇文章的核心思想是利用非对齐的图像迁移其特征到待SR的特征上,因为特征层面对于颜色光照变化更加鲁棒。整体网络框架如下:

特征交换

匹配特征是在patch层面上进行的,同时为了衡量相似性,要令ref图片的频率和LR的频率一致,这里对其进行上下采样模糊化。计算LR的 i-th patch和模糊化参考图像 的 j-th patch的相似性的计算公式如下,这里patch做了归一化(P表示采样patch):

可以用卷积和互相关加速这个过程:

这里Sj表示的是对第J个 ref patch对LR的相似性,所以这里相当于一个ref特征的归一化结果对LR进行卷积,得到相似map。因为ref patch是多个的,所以这里相当于做了多个卷积,得到的相似图也是多次运算之后的结果。最后选择LR各个位置相似性最高的ref patch,将它们组合构成交换图,如下所示:

由于每一个位置对应一个Ref patch,所以这些patch是重叠的,在重叠位置取平均。这里迁移纹理使用的原始的ref 图,而计算相似性使用的是上下采样过后的图。

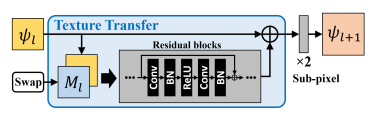

纹理迁移

这里将LR特征和交换特征concat在一起,通过一个残差网络做纹理迁移,然后通过subpixel进行上采样,结构图如下:

损失函数

损失函数的目标是(1)保存LR图像的结构信息,(2) 改善SR图像的视觉效果, (3)利用ref 图像的纹理信息。包括

Reconstruction loss: 这里是计算SR与HR的L1 loss:

Perceptual loss: 计算VGG-19的relu5_1层的feature loss:

Adversarial loss:用 WGAN-GP计算HR和SR图像的WGP-GAN loss

此外还有一个特征转换过程中的迁移loss,用来使得Ref的纹理和SR的纹理尽可能接近,这里使用相似map作为权重,抑制不相似纹理的惩罚,放大相似纹理的惩罚:

其中Gr表示Gram矩阵。

实验结果见论文。