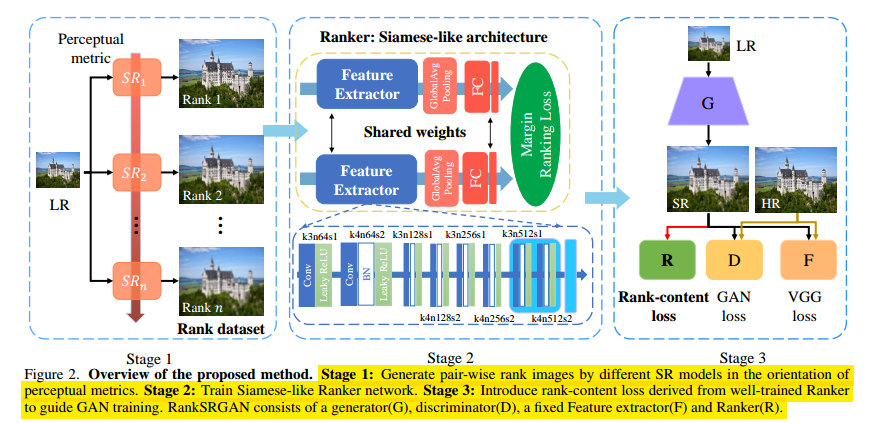

2019 ICCV的一篇oral,借鉴美学评价里的相对质量用在图像超分辨里作为loss,从而从可量化的角度优化SR的感知质量。论文主要是分成三个步骤,分别是获得排序的数据集,训练排序器ranker,和训练rankSRGAN。整体流程图如下所示:

论文的一个出发点是,ESRGAN并不是总比SRGAN的效果要好,所以可以使用一个ranker去挑选出两个方法里输出图片表现较好的那个,表现的评价指标是NIQE。因此借助这个ranker训练出来的模型结合了ESRGAN和SRGAN的长处,不得不说这个想法非常的有意思三个步骤分别如下:

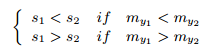

首先是构建rank dataset,这里获得两个SR算法分别处理之后的结果,它们的label通过guality score获得,就是上面提到的一些感官指标。两张图送到rank评价器里之后获得分数s1、s2,因为要让ranker输出结果获得和输入图感知质量相同的排序而不是分数,这里令输出分数满足下面:

然后是构建ranker,如上面图里,其实是一个共享权重的双路网络,最后通过全连接输出分数,结构上没什么好说的。这里使用的loss是margin-ranking loss,表示为:

其中$\gamma$是label为1或者-1,自然的这里 $\gamma > 1$ 时,希望s1 < s2,反之亦然。ranker优化目标就是这个loss。

最后一步就是rankSRGAN,这里使用了之前SRGAN里的VGG loss和GAN的loss,同时还使用了上面的rank输出结果作为loss,这里对输出使用sigmoid归一化到0到1之间,值越小代表感知质量越好。

论文还增加了一步,就是认为ESRGAN的感知质量始终优于SRGAN,并训练一个ranker,然后说明这个ranker不如前面提到的ranker。详细见论文。

最后论文通过一系列的实验说明其在感知指标和PSNR上均优于SRGAN和ESRGAN。并且有较好的user study结果。