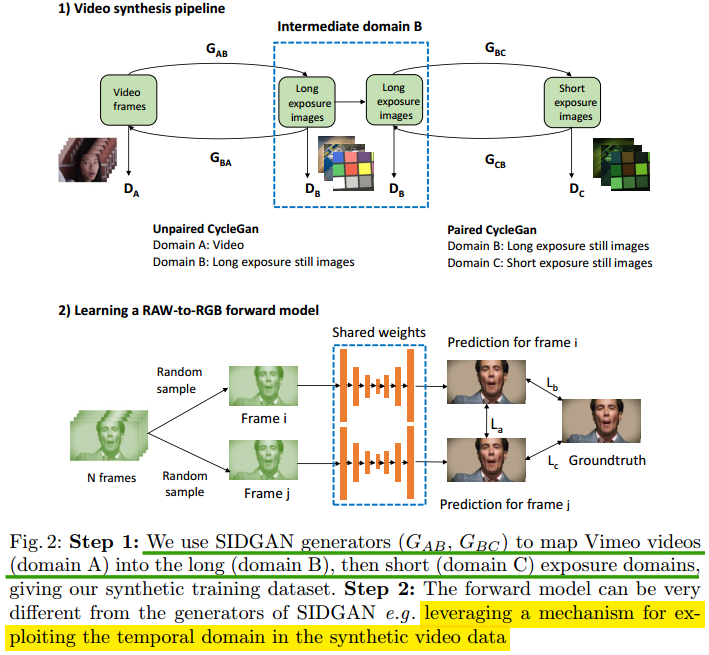

2020 ECCV,通过仿真图像合成真实场景video用于低光video增强。目前现有的增强方法都只局限于静态场景以及特定内容,对于动态等场景不使用。论文的出发点是将互联网上的video转换成低光照video,但是直接转过去难度较大,所以通过一个长曝光图像作为中介。最后从而合成大量的仿真pair数据集。论文整体框图如下所示:

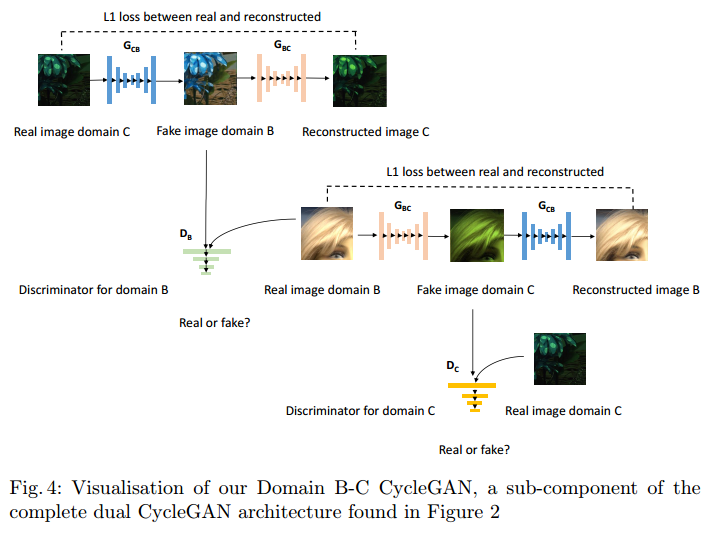

可以看出,论文是使用了两个类似cycleGAN的方式进行训练,分别从正常Video A转换到长曝光图像B,以及长曝光图像B转换到短曝光图像C。其中A到B是unpaired的,而B到C转换是paired的。A到B转换的loss如上所示,主要包括两个GAN loss,以及cycle loss和identity loss。B到C的转换loss则为两个GAN loss,以及cycle loss和supervise loss。B到C转换的cycleGAN如下所示:

得到pair的数据后,对于增强网络使用的是一图下半部分的那个网络。训练时先在静止数据集上训,然后仿真数据上finetune。最后在静止数据上finetune。论文使用的GAN均为Patch GAN。具体实验对比参考论文,感觉效果还是非常惊艳的。