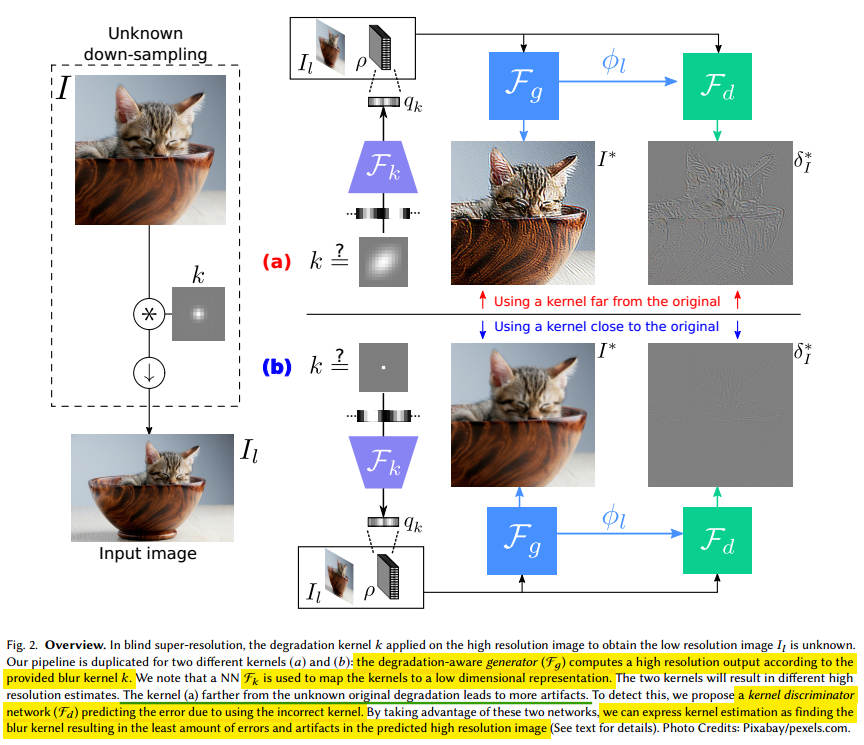

2019 sigraph论文,只看懂了一些皮毛,有不足请指正。其出发点是,估出不准确的核会导致SR的结果也是不准确的,因此,需要估出一个准确的核,这里通过在HR空间下进行误差调整实现估核。即,先提供一个初始LR和初始核,然后通过两者得到一个SR图像,并通过一个核判别器去分析估计的核对于生成结果的误差。最后,通过最小化核估计误差进行优化,从而得到较为准确的估计核和SR图像。整体的pipeline如下所示:

可以看出,核k首先被映射到空间q上,通过网络F实现,F是一个两层的全连接网络。当然这个核k也可以是空间各异的。超分辨网络也就是图中的Fg,是一个通用的超分辨网络,其同时输入核q和图Il,输出通过与I做l1 loss,对网络进行优化,当然这种训练只能针对于核k已知的情况。

当核未知时,上面提到的方法可以合成一个原始的SR结果。不准确的核会导致结果出现artifacts,所以这里提出一个核判别器Fd。Fd输入是q,Il和Fg的最后一层feature map,输出是残差结果,因此如上图所示,最小化估计核的残差和GT的残差,是Fd的loss。

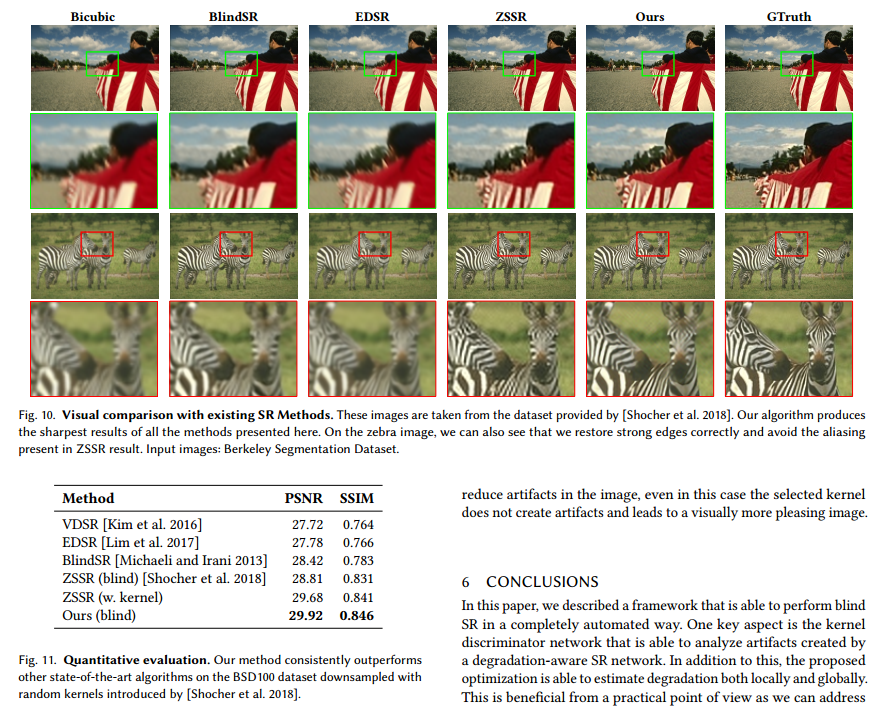

因此,整体的优化就是要优化估计的核k,直接要估计的就是降质map q,主要通过对核空间进行遍历得到。当然这个过程是很慢的,本人在1080ti上inference这篇论文的预训练模型,发现速度慢的惊人。论文的部分的结果如下所示:

具体细节可直接参考论文。