BidNet: Binocular Image Dehazing without Explicit Disparity Estimation

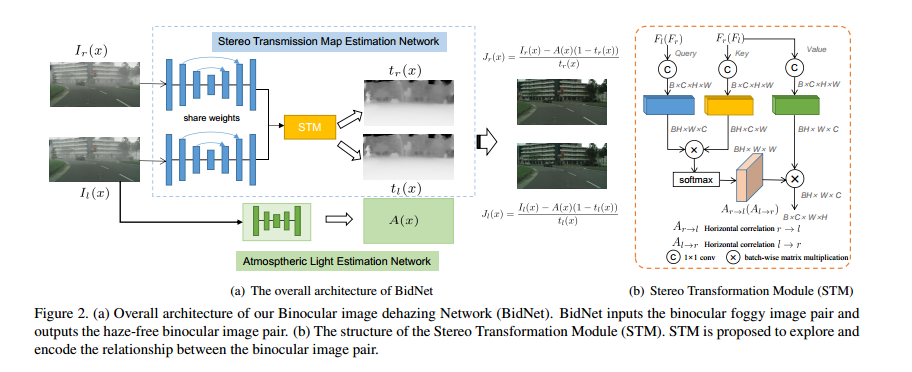

2020 CVPR,现有的基于双目去雾的方法需要显式的去估计深度和去雾,而对深度估计的不准确会导致去雾效果不好,因此这里对双目信息进行隐式的利用,因此减少的3D卷积运算也可以提速,此外目前的方法只能得到一个视角的去雾结果。整体架构如下所示:

可以看出,这里对左右视图信息的联合利用通过一个non-local模块实现的,这个nonlocal操作的方向是水平的,提取特征时使用的是一个encoder-decoder式的一个网络,nonlocal后的结果经过一个多尺度池化refine从而得到最终的transmission结果。而大气图是全局的且左右视图一致,这里通过一个encoder-decoder网络直接从输入图得到。

损失函数方面,这里包括去雾结果的左右视图及refine之后的左右视图分别和GT算法loss,对transmission图也做了同样的loss,以及一个大气图与GT大气图的L2 loss,最后还加上了一个VGG loss。在实验上,这里是在Cityspace数据集上进行仿真的,同时对于真实场景,这里在DrivingStereo数据集上进行仿真,然后在其真实的带雾图上进行测试。博客https://blog.csdn.net/qq_43310834/article/details/108347191 感觉比我说的清楚。

Disparity-Aware Domain Adaptation in Stereo Image Restoration

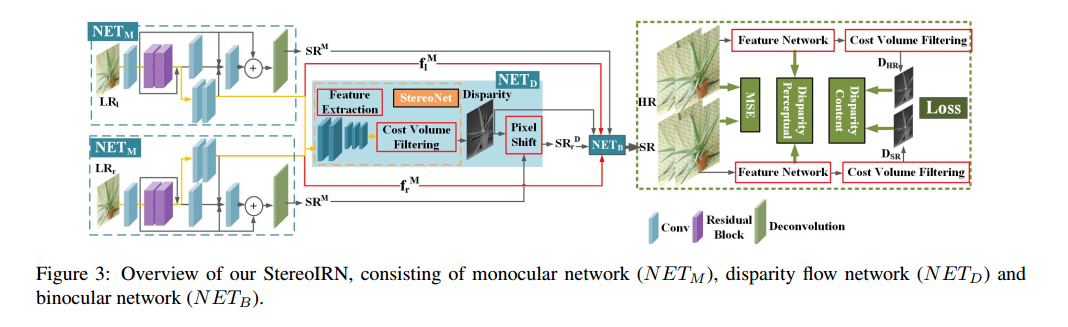

2020 CVPR,做双目图像恢复。双目图片可以提供另一个视角的信息,因此更加有利于图像恢复任务。之前Stereo process的网络仅仅利用disparity信息进行深度估计。因此论文提出的方法要将disparity的信息利用起来,辅助图像恢复。整体结构如下所示:

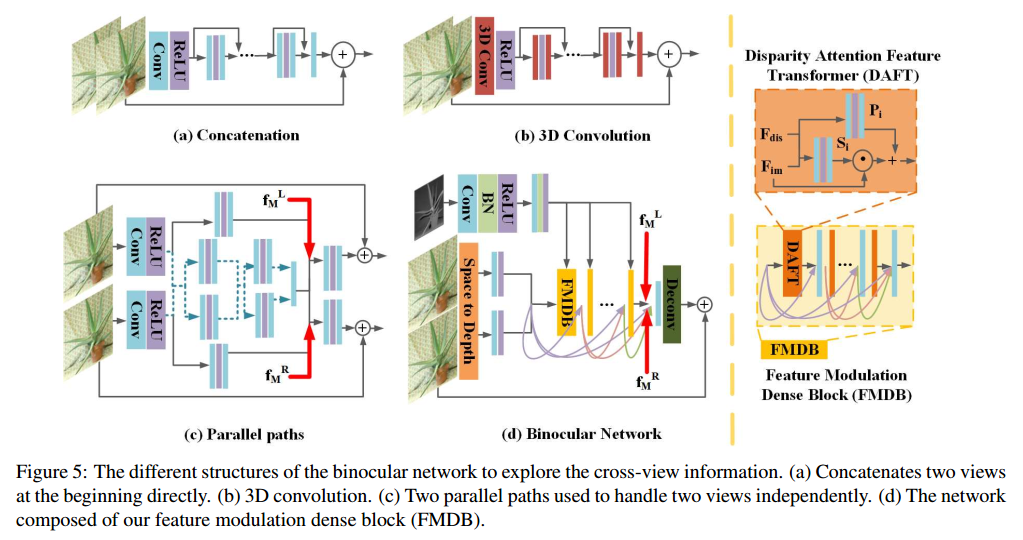

包括单目网络,视差网络和双目网络,其中单目网络分别对各个视角的图像进行恢复,从而为提供视差先验做准备。该部分分别输出fM和IM分别对后面的双目网络进行性能提升。而对于视差网络,这里是在特征层面上进行处理,因此可以有效克服domain差异,最后是双目网络,这里采用的结构和以往其他双目网络的差别如下图所示:

显然(a)和(b)的方式都过于简单粗暴,而(c)这种处理虽然被交叉式的处理,但是没有利用视差先验。所以论文使用了如d所示的结构,即通过密集连接的FMDB实现视差先验的利用。为了减少计算量,这里使用space to depth的方式减少分辨率去实现。具体操作见上图。

损失函数上,这里包括一个disparity上的L1 loss和perceptual loss,在训练策略上,这里先对单目网络和视差网络分别使用输出结果和视差结果做loss,然后固定视差网络,对单目网络和双目网络进行finetune。在训练数据上,这里使用 Middlebury dataset,但是我感觉这里仿真处理的非常随意,总之可以做的点还是有的。

Beyond Monocular Deraining: Stereo Image Deraining via Semantic Understanding

2020 ECCV,使用双目做derain,同时结合语义信息引导这个过程。双目信息可以提供更多几何信息可以辅助去雨。详情见:https://my.oschina.net/u/4579551/blog/4619830