这是2018cvpr的一篇论文,和一般使用网络进行学习的方法不同,这篇文章认为人们设计的网络本身就可以提取出图像大量的先验信息,网络本身就相当于一个人为的特征提取方式。论文使用随机初始化权重的CNN网络,然后基于给定的图片和其所依赖的任务,通过迭代使得模型参数逼近极大似然。论文将图像的inverse problem写成以下的形式:

其中E根据任务不同选择不同,R是一个正则项,依赖于自然图像的先验,而$x_0$是待复原的图像,这里将R用一个神经网络来代替,则网络的参数学习如下:

这里的z为网络的输入,是随机的初始化值,$\theta$是网络参数,通过在可行空间搜索得到,一般使用梯度下降法,学习到最佳参数后,对z进行编码,实际上编码z的过程也可以优化,但是在本文中直接random后就固定下来。所以其基本的处理方法流程如下:

1.随机初始化输入z。

2.将退化后的图像,例如低分辨或者带噪声的图像,作为网络要拟合的对象,进行训练,生成退化的图像。

3.可以得到网络会先拟合得到natural-looking的图像,然后再进行退化,因此需要在某个比较合适的训练步骤停止,即认为找到使得E最小的$\theta$。

4.最后在截断处输出图像,即$x^=f_\theta ^(z)$

上述的R(x)是一个先验,一般当R(x)=0时,图像可以基于一个具体的CNN从输入z中得到,R(x)=inf时,其为其他信号。这个基于先验的R(x)对于各种图像恢复任务来说效果还是很好的。

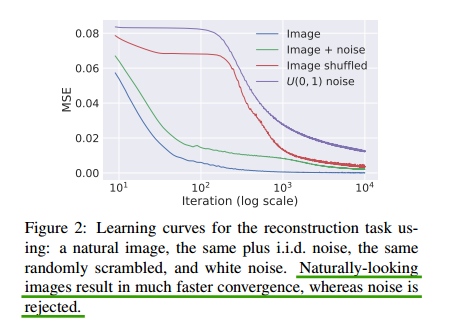

对于网络,这里选择的是一个encoder-decoder的结构,输入采用渐变的图像作为输入,会增加平滑先验。从下图可以看出自然图像还是很容易获得的,而噪声就比较难以拟合,也就是说,参数与噪声之间是高度独立的,因此可以用来做快速去噪。

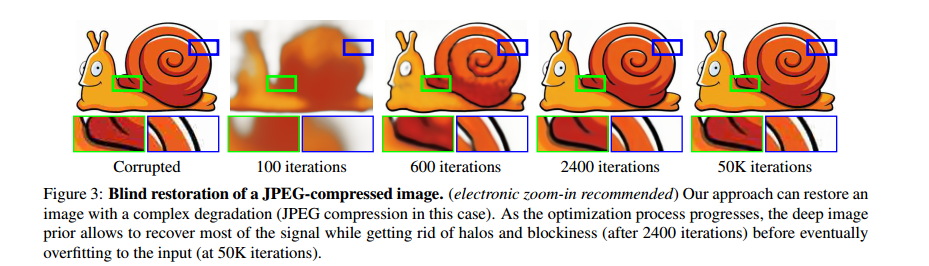

最后一个恢复的例子如下所示,随着迭代次数的增加,图像逐渐恢复到自然图像。

总之,论文说明了CNN在学习的过程中,一般是学习图像中自然的部分,然后再学习degrade的部分,其具有天生学习图像结构的能力。