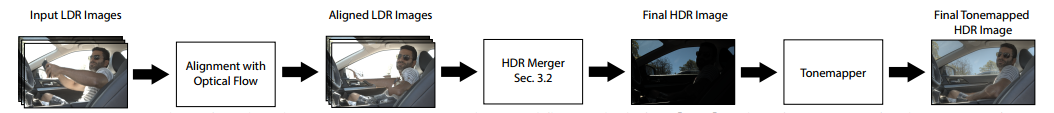

这是2017 Sigraph的一篇论文,目标是从一组不同曝光的图像中生成高动态范围(HDR)图像。现有HDR技术首先将输入图像对齐到参考图像,然后将对齐的图像合并得到HDR图像。然而,在最终的HDR图像中,对齐的artifact通常以重影和撕裂的形式出现。论文观察到在合并时可以有效的减少这些artifact,通过检测带有artifact的区域,并将它们从最终结果中排除。论文训练时输入的是三个有不同曝光度的一系列LDR图像,先使用光流进行对齐,然后将对齐的图像送到网络里获得高动态范围的HDR图像。GT图像数据集制作是通过三张不同曝光度的静态图像组合生成的,详见论文。流程图如下:

具体的处理流程是,首先将图像通过CRF和gamma校正进行变换,将图像转换到肉眼可接收范围内。然后将高曝光图像Z1和低曝光图像Z3对齐到中等曝光度的图像Z2里,这里使用光流法进行对齐,需要光照一致性,详见论文。对齐好的图像I1,I2,I3送入融合网络里,该部分包括Loss和模型部分。对于Loss,因为最后展示的图像是tone mapping之后的,所以这里也对输出的图像进行这样的处理,然后计算Loss,如下所示:

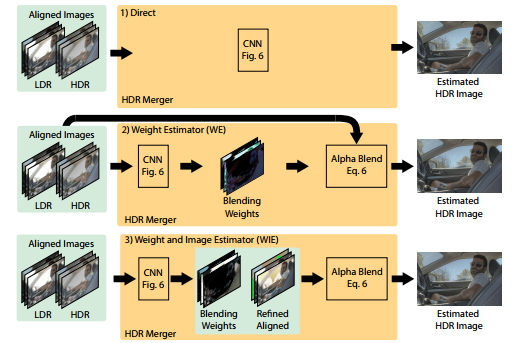

这里3代表三个颜色通道。在模型进行图像融合,这里需要LDR domain可以检测出饱和和噪声区域。例如,一个简单的规则是考虑所有较小的像素(小于0.1)以及较大的像素(大于0.9)分别代表噪声和饱和区域。所以实际输入是对齐的图像I和校正后的HDR图像H,论文提出三个架构,分别如下:

如上图所示,第一种是直接将图像送进去,然后产生输出图,但是这样很容易产生artifact。第二种方式是产生三个权重图,并将其和输入的HDR图像相乘,然后组合在一起生成最后的HDR图像,可以减少artifact但是输出图的信息仍然是从输入图得来的。第三种方式是产生refine过后的图像和权重图,并对其进行组合,这里先对refine的图像进行约束,使其和输入的图像L2 loss尽可能变小,然后训练权重图,使得整个网络进行优化。其他部分详见论文。