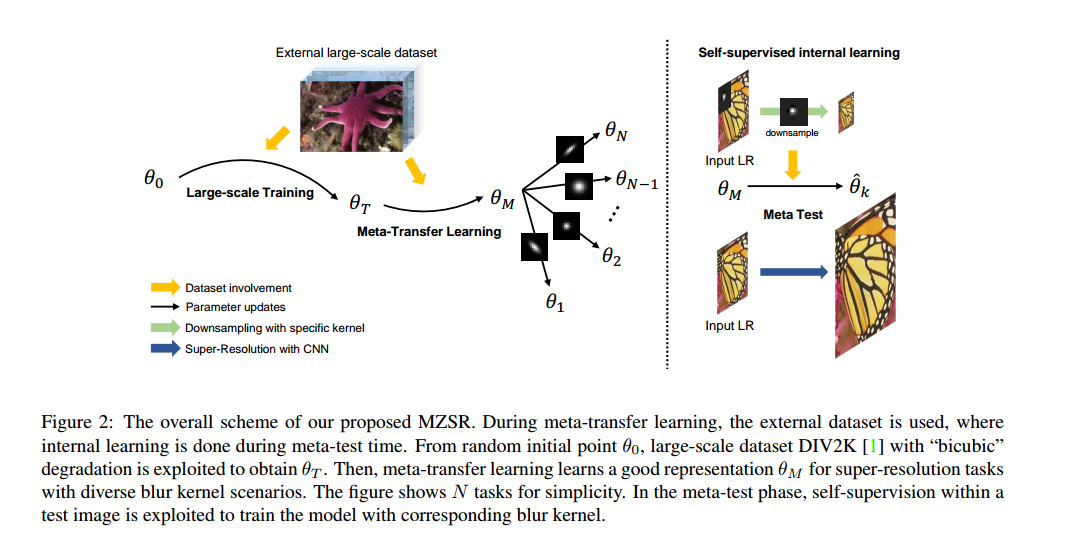

2020 cvpr,使用meta learning做0样本超分辨;和前面那篇去噪的idea比较像的,只不过这个针对的是0样本,而去噪那一篇针对的是少样本。本论文针对之前ZSSR这篇论文存在的两个问题,一个是其需要大量的迭代次数,其次其没有利用外部数据集提供的大量的统计先验,仅仅依赖自身的内部信息关联性。针对此,论文提出使用迁移学习去迁移在外部数据集获得的模型,从而获得外部数据集的统计先验。然后使用meta learning里的MAML策略,根据降质模型核的数据去更新网络参数,最后在测试的时候根据测试数据使用自监督的形式更新参数。所以这篇论文名义上是0样本,实际上也是迁移学习的应用,和之前那篇去噪的是近似的。论文的整体framework如下所示:

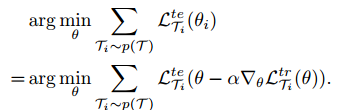

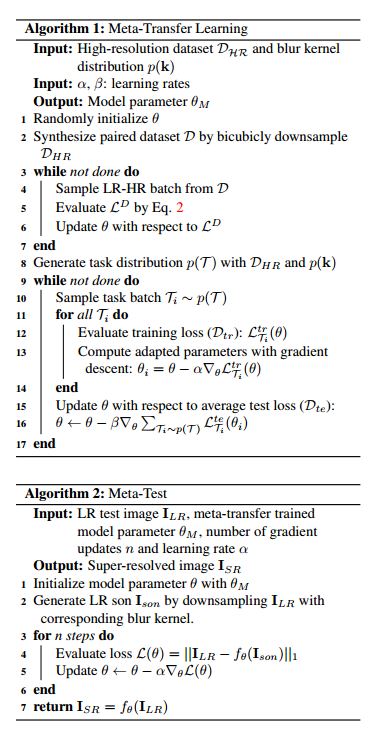

第一步是使用bicubic下采样的大量图片进行训练,获得一个初步的模型。然后使用meta learning,使用的仍然是外部数据集监督的方式,这里使用的是特定的下采样方式,优化目标如下所示:

最后是进行meta-test,这里使用自监督的方式进行,也就是论文里的0样本学习。通过对给定的测试图片使用模糊核建模的方法,对齐进行下采样,然后通过对参数进行更新,进行自监督学习。实验时这里只更新参数五次,当然这样在原来模型训练好的基础上进行微调,效率是比ZSSR上好很多的。论文的整体算法流程如下:

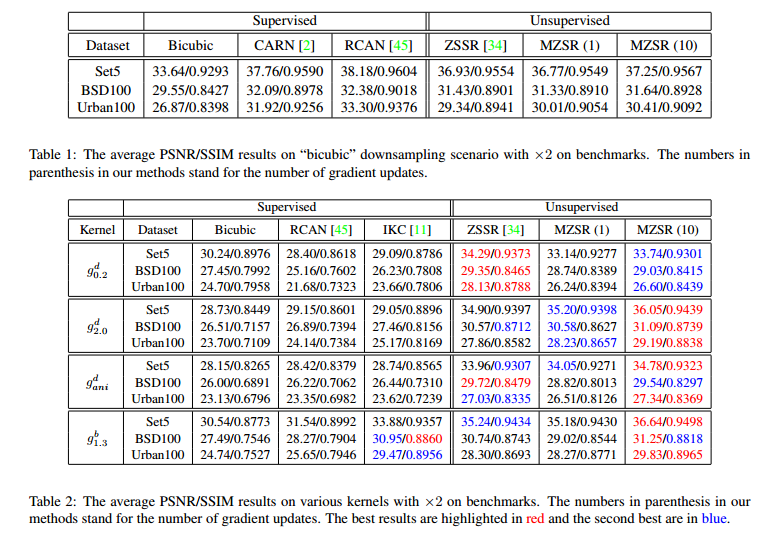

最后是部分实验结果,表一里在bicubic训练bicubic测试,所以原来的有监督方法RCAN等会表现较好,表二里RCAN等直接在其他降质上测试,所以性能drop严重。