这是我本人所做的第一个比较正式的深度学习项目,现在项目做完已经两三个月了,写一下对这个项目的总结。

首先项目的目的,即利用kinect相机获取的RGBD图像,分别将其RGB特征和深度特征提取出来,进行融合,最后实现分类,并在目标检测框架下实现目标检测。其实我一直觉得,这个项目完全可以把初始图片变成4通道的图像,然后随便找一个分类网络做就行了。不过既然是老师要求做特征融合,那么我也只能用两个通道的网络去做了。

融合网络该怎么设计,这个问题很重要,我参考了一些特征融合的论文,决定用稀疏自编码器先提取图像的低维特征,低维特征的图如下:

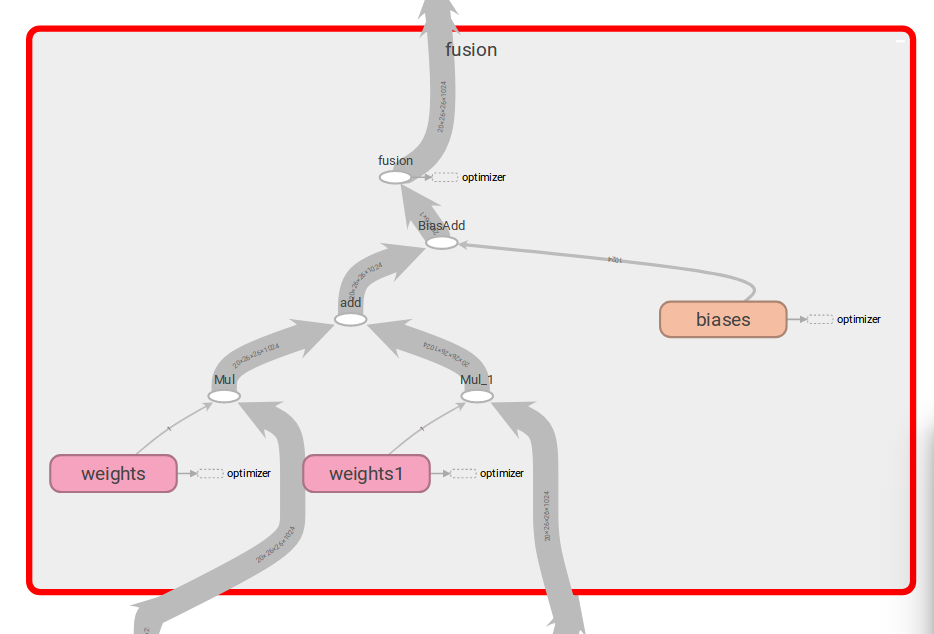

然后再使用卷积神经网络提取图像的高维特征,再对两个特征各自赋上一个自适应的权重,进行相加,融合层示意图如下:

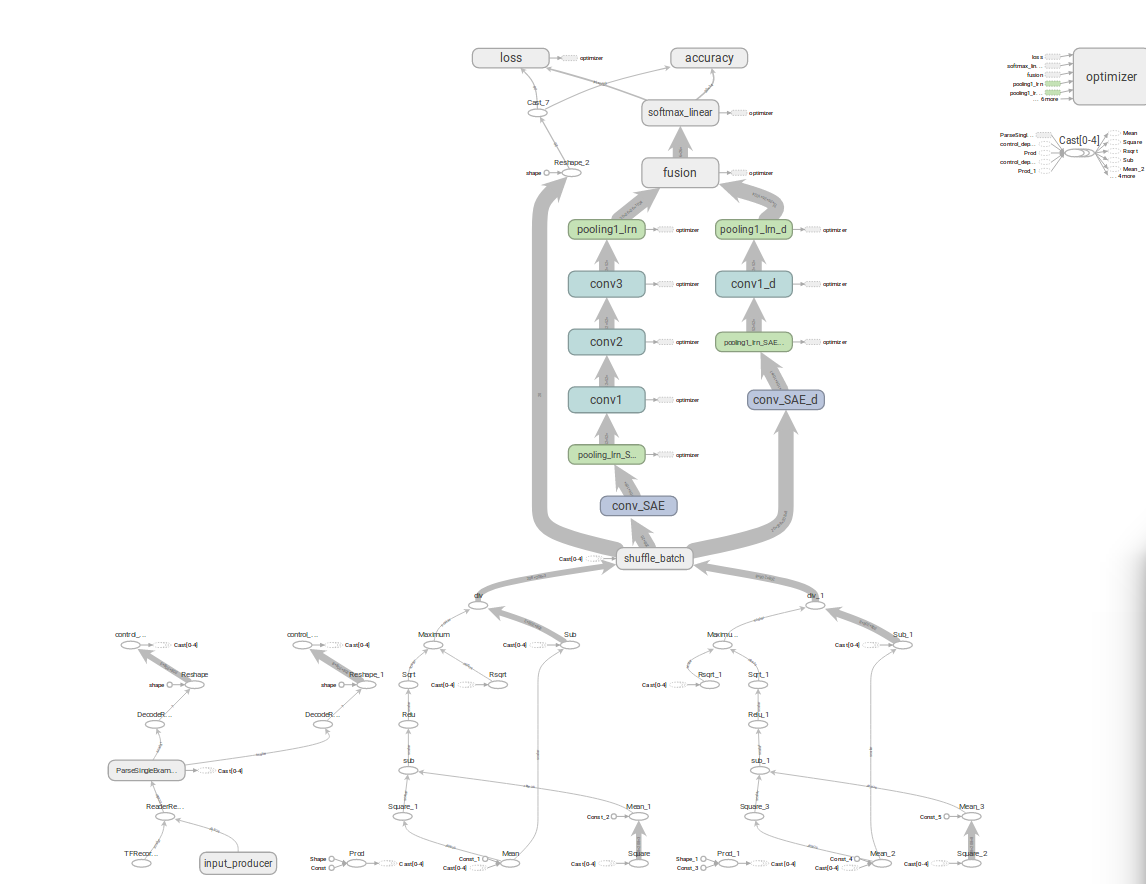

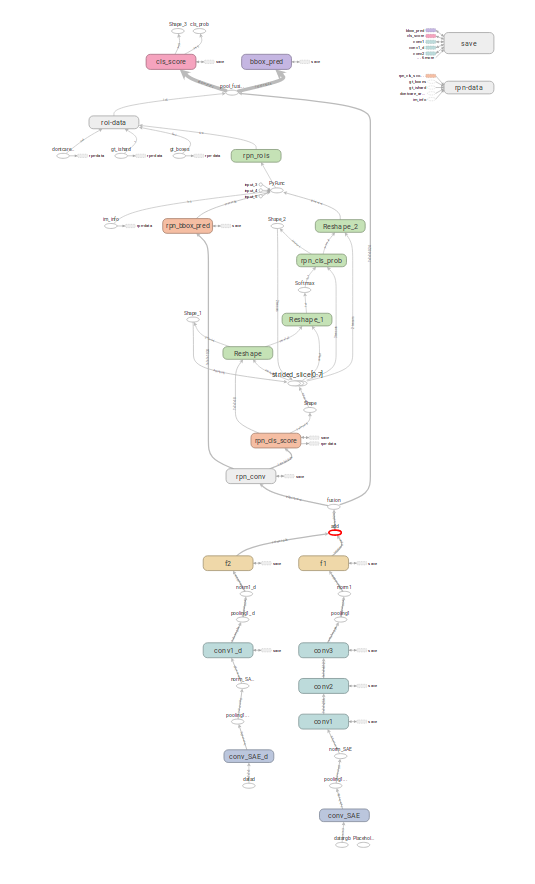

最后送将融合特征入全连接层,就实现了分类,整个网络框架如下:

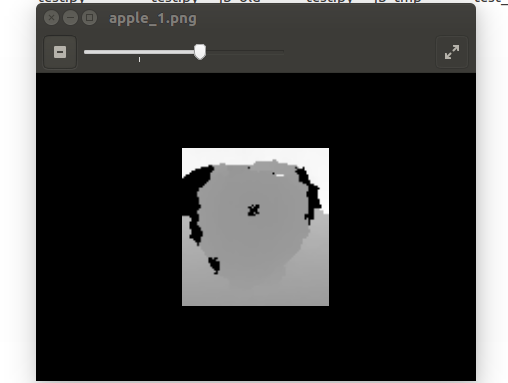

至于网络为什么这么浅嘛,因为我在训练深度图的时候发现,对于深度特征而言,网络深度越深,分类正确率反而会下降,对此我将深度图的网络设计为只有一层,同时使用了预处理手段,增加了图像的对比度,使得特征更明显,预处理前后示意图如下(左原图,右结果图):

对于RGB图像,由于所要分类的物体特征不是很复杂,没必要把网络搞得太深,这样我将RGB网络设计为了三层,使网络整体大小合理。

最后,将上述设计好的网络放在faster-rcnn框架下进行训练,网络整体示意图如下:

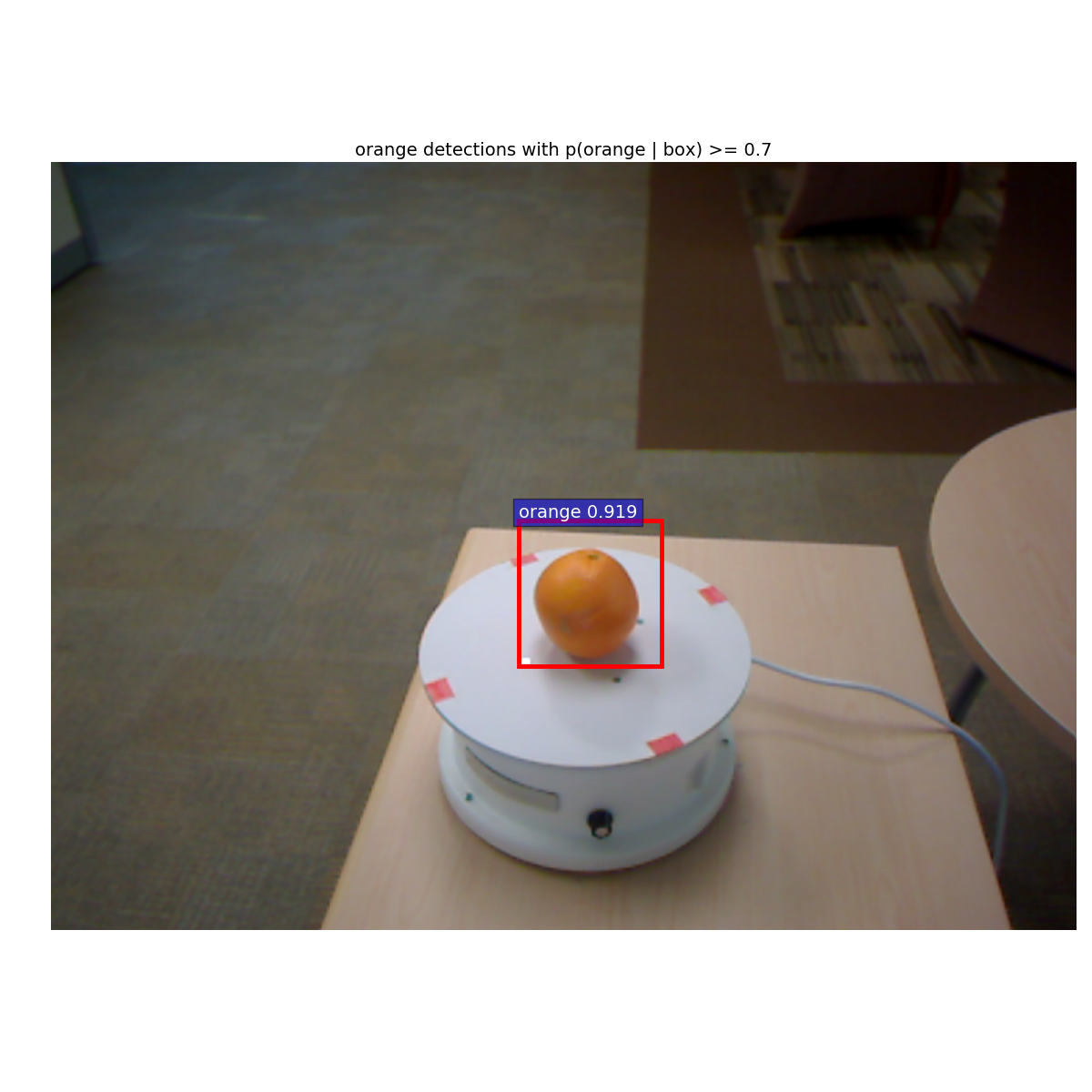

目标检测示意图如下所示,这样这个水项目就做完了,也算是锻炼了基本的调参能力了。

相关代码以后有时间上传到github上,毕竟只是修修改改,感觉很low,希望不要被笑话。