这是一篇用强化学习做增强的论文,使用调色的方法对图像做增强,相关思路可以借鉴。这里进行简要了解,个人感觉这篇论文对图像的增强可以归类为全局调色的方法,与之对应的是局部调色的方法和生成的方法。

论文主要的方法有以下三个优点,首先,其是一个端到端主要学习变换算子的方法,因此其可以处理任意大小的图片。其次,论文使用的强化学习可以给出自己每一步调色所做的操作,这样对图像的处理就不再是一个黑箱,从而方便人们自己根据学习得到的这些参数自己手动调节。最后是论文结合自己的方法和GAN,从而使得图像可以进行非成对的学习,并且基本不产生artifact。

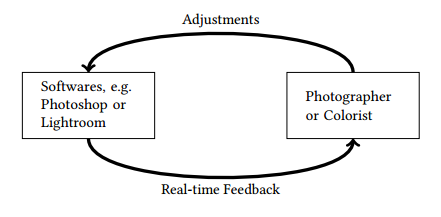

这里的调色是将图像处理过程分解为一系列的操作过程,每个操作过程对应于强化学习里的一个决策过程,通过对这些决策过程的结果进行惩罚就可以实现训练,一个示例图如下:

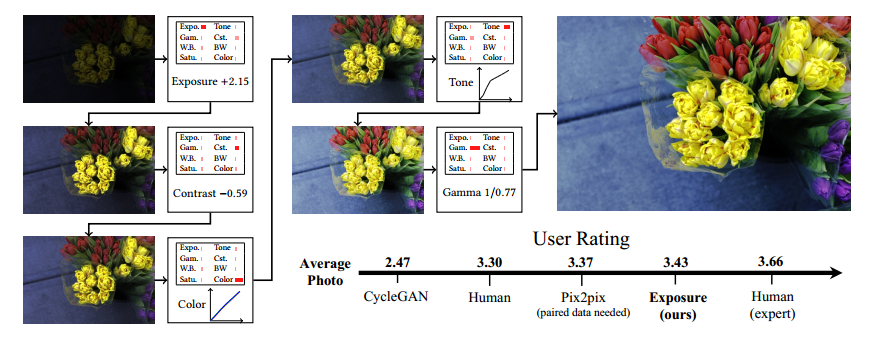

然后论文就开始介绍强化学习的理论部分,这部分略去。总之就是网络的学习是根据每一步状态获得惩罚或奖励,最后使得总的惩罚或奖励达到最优状态,这个状态对应于图像质量最佳的状态。网络调整图像状态所对应的具体操作如下图所示:

可见整个决策过程包括曝光度的调整,对比度、色度、伽马校正等过程,其每一步调整的结果可以通过梯度的回传被整个网络学习,从而改变每一步的调整参数。具体的调整过程涉及到强化学习的细节,这里本人不懂,总之是通过每一步调整中参数值的梯度进行学习的。最后加上一个GAN,其增量为强化学习架构奖励的负值,从而使得生成图像和目标图像具有更高的感官相似。

在训练过程中,其对于过于使用的决策过程进行惩罚以避免陷入局部最优。此外,有时强化学习架构会连续使用两个相同的操作例如两次exposure而这完全可以使用一个操作步骤完成,因此遇到这种情况也会增加惩罚从而鼓励使用不同的操作。最后,训练中会将一部分图像只做一次操作然后就进行状态比较,这样做类似于正则化,有利于避免模型震荡。

结果略过,这个图像调色的过程可以被借鉴,以及如何使用参数的梯度进行学习是一个值得研究的问题。