这是2018年ACMMM的一篇论文,其主要是使用生成对抗网络做弱监督的图像增强,其生成网络部分使用了基于全局调色的方法。在弱监督的学习里,这里使用了两个判别结果即生成的图像是否是增强图像。这里主要了解一下其生成网络的工作机制。

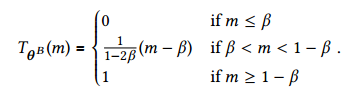

生成网络的基本架构是Resnet网络,将最后的pooling层去掉,所以最后是2048个feature map,这篇文章主要是对这个feature map做操作。

Piecewise Color Enhancer.

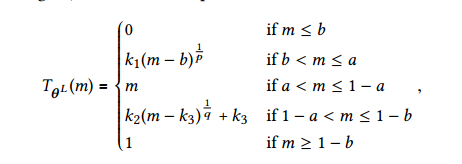

这个部分主要是对图像的亮度和色度做增强,在CIE通道里,亮度体现在一个通道而色度则体现在两个通道里。这里调整亮度和色度的方式是遵循gamma变换的方法,其中亮度方面的调节使得过暗区域变亮而较亮区域变暗,因此其亮度变换公式如下:

其中超参是a,b,p,q,上述公式保证函数整体是连续的。

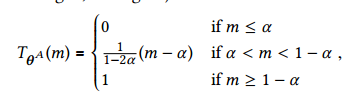

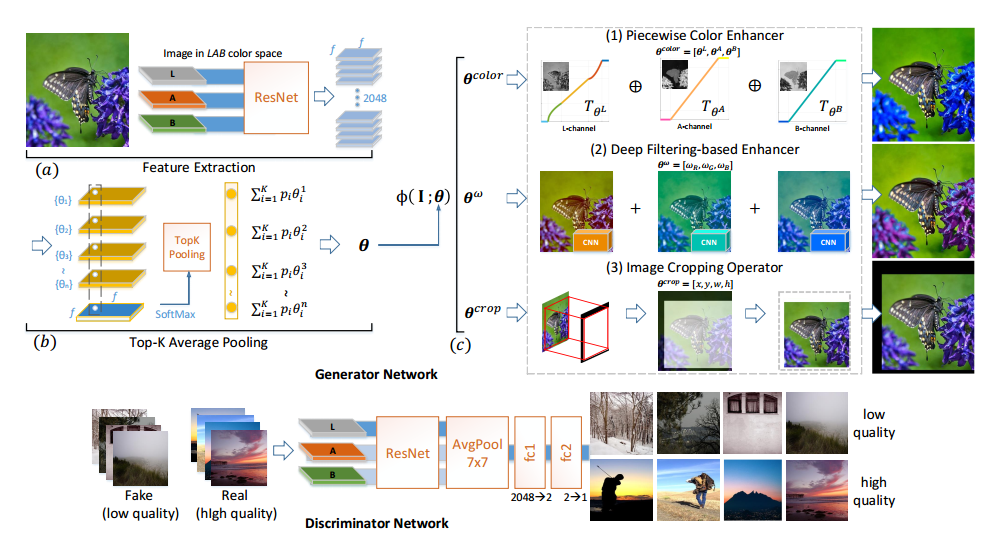

然后是对色度进行变换,遵循LAB颜色移动准则,变换公式分别如下:

这样色度和亮度的超参是六个,即上述四个加上$\alpha、\beta$,这些参数是通过上面的2048个特征map得到的。这里通过1x1的卷积将上述的2048个feature map变成7个feature map,其中前面六个对应上面的六个超参(每个有fxf个参数,这是feature map的大小),第七个表示前面fxf个六参数组合里可能性的softmax,取出最大可能性的K组然后做全局平均池化(论文里称为Top—K average pooing),从而获得六个参数,图如下所示:

Deep Filtering-based Enhancer

piecewise color enhancement仍有一定限制,这里可以将上述公式变成一个更加通用的公式,通过学习系数将上面的操作算子$\phi$组合起来,而这个系数也是通过feature map得到的,假定最后要学习n个系数,那么需要从2048变成n+1层,其中第n+1个层表示fxf的softmax可能性同上,获得系数也是通过Top-K pooling的方式。组合的公式如下:

这里设定RGB三色作为$\Phi$的目标,每个$\Phi$通过三层网络学习获得,具体可如上图所示。

Image Cropping Operator

这里和上面比较相似,只不过这里是学习crop的四个参数(x,y,w,h),所以最后的网络参数是五层。最后

为了使得参数可以回传到crop的参数,这里对输入图像进行子采样,从而方便回传。

最后,网络使用的损失函数是基于GAN的损失和基于VGG特征的损失,后面结果等不再赘述。